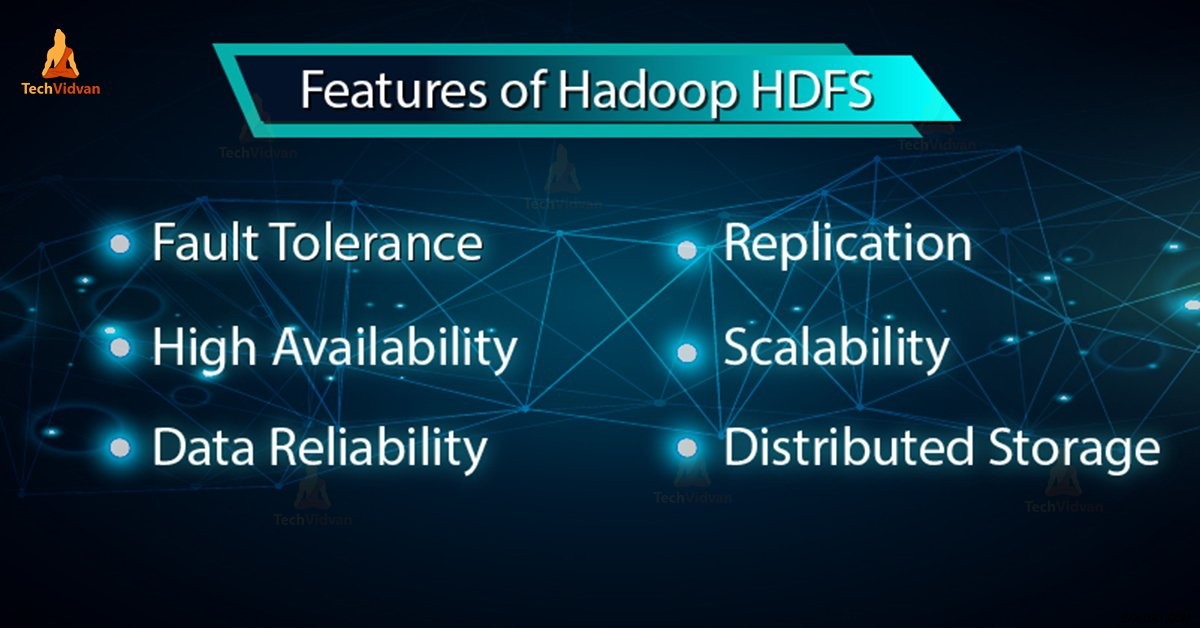

I vår tidigare blogg har vi lärt oss Hadoop HDFS i detalj, nu i den här bloggen, kommer vi att täcka funktionerna i HDFS. Hadoop HDFS har funktioner som feltolerans, replikering, tillförlitlighet, hög tillgänglighet, distribuerad lagring, skalbarhet etc.

Alla dessa funktioner i HDFS i Hadoop kommer att diskuteras i denna Hadoop HDFS-handledning.

Introduktion till Hadoop HDFS

Hadoop distribuerade filsystem (HDFS) är Hadoops primära lagringssystem. Den lagrar mycket stora filer som körs på ett kluster av råvaruhårdvara. HDFS är baserat på GFS (Google FileSystem). Den lagrar data på ett tillförlitligt sätt även vid hårdvarufel.

HDFS ger också åtkomst med hög genomströmning till applikationen genom parallell åtkomst. Enligt en förutsägelse i slutet av 2017 kommer 75 % av den tillgängliga informationen på planeten att finnas i HDFS.

6 viktiga funktioner i HDFS

Efter att ha studerat Hadoop HDFS introduktion, låt oss nu diskutera de viktigaste funktionerna i HDFS.

1. Feltolerans

Feltoleransen i Hadoop HDFS är arbetsstyrkan hos ett system under ogynnsamma förhållanden. Den är mycket feltolerant. Hadoop-ramverket delar in data i block. Efter det skapas flera kopior av block på olika maskiner i klustret.

Så när någon maskin i klustret går ner, kan en klient enkelt komma åt sina data från den andra maskinen som innehåller samma kopia av datablock.

2. Hög tillgänglighet

Hadoop HDFS är ett mycket tillgängligt filsystem. I HDFS replikeras data bland noderna i Hadoop-klustret genom att skapa en replik av blocken på de andra slavarna som finns i HDFS-klustret. Så närhelst en användare vill komma åt denna data kan de komma åt sina data från slavarna som innehåller dess block.

Vid tidpunkten för ogynnsamma situationer som ett fel på en nod kan en användare enkelt komma åt sina data från de andra noderna. Eftersom duplicerade kopior av block finns på de andra noderna i HDFS-klustret.

3. Hög tillförlitlighet

HDFS ger tillförlitlig datalagring. Den kan lagra data i intervallet 100-tals petabyte. HDFS lagrar data på ett tillförlitligt sätt i ett kluster. Den delar upp data i block. Hadoop-ramverket lagrar dessa block på noder som finns i HDFS-klustret.

HDFS lagrar data på ett tillförlitligt sätt genom att skapa en kopia av varje block som finns i klustret. Ger därför feltoleransmöjlighet. Om noden i klustret som innehåller data går ner, kan en användare enkelt komma åt denna data från de andra noderna.

HDFS skapar som standard 3 repliker av varje block som innehåller data som finns i noderna. Så data är snabbt tillgänglig för användarna. Därför står användaren inte inför problemet med dataförlust. Således är HDFS mycket tillförlitligt.

4. Replikering

Datareplikering är unika egenskaper hos HDFS. Replikering löser problemet med dataförlust i ogynnsamt tillstånd som hårdvarufel, kraschar av noder etc. HDFS upprätthåller replikeringsprocessen med regelbundna tidsintervall.

HDFS fortsätter också att skapa repliker av användardata på olika datorer som finns i klustret. Så när någon nod går ner kan användaren komma åt data från andra maskiner. Det finns alltså ingen möjlighet att förlora användardata.

5. Skalbarhet

Hadoop HDFS lagrar data på flera noder i klustret. Så när kraven ökar kan du skala klustret. Två skalbarhetsmekanismer finns tillgängliga i HDFS:Vertikal och Horisontell skalbarhet.

6. Distribuerad lagring

Alla funktioner i HDFS uppnås via distribuerad lagring och replikering. HDFS lagrar data på ett distribuerat sätt över noderna. I Hadoop delas data in i block och lagras på noderna som finns i HDFS-klustret.

Efter det skapar HDFS repliken av varje block och lagrar på andra noder. När en enskild maskin i klustret kraschar kan vi enkelt komma åt vår data från de andra noderna som innehåller dess replik.

Slutsats

Sammanfattningsvis kan vi säga att HDFS är mycket feltolerant. Den lagrar på ett tillförlitligt sätt enorma mängder data trots hårdvarufel. Det ger också hög skalbarhet och hög tillgänglighet. Därför ger HDFS Hadoop-funktionalitet. Om du hittar någon annan funktion i HDFS, så vänligen dela med oss i kommentarsavsnittet nedan.