Relationella databaser räckte länge för att hantera små eller medelstora datamängder. Men den kolossala hastigheten med vilken data växer gör den traditionella metoden för datalagring och hämtning omöjlig. Detta problem löses av nyare teknologier som kan hantera Big Data. Hadoop, Hive och Hbase är de populära plattformarna för att driva den här typen av stora datamängder. NoSQL eller inte bara SQL-databaser som MongoDB® tillhandahåller en mekanism för att lagra och hämta data i förlorarkonsistensmodell med fördelar som:

- Horisontell skalning

- Högre tillgänglighet

- Snabbare åtkomst

MongoDB®-ingenjörsteamet har nyligen uppdaterat MongoDB® Connector för Hadoop för att få bättre integration. Detta gör det enklare för Hadoop-användare att:

- Integrera realtidsdata från MongoDB® med Hadoop för djupgående, offlineanalyser.

- Anslutningen exponerar den analytiska kraften hos Hadoops MapReduce för live applikationsdata från MongoDB®, vilket skapar värde från big data snabbare och mer effektivt.

- Anslutningen presenterar MongoDB som ett Hadoop-kompatibelt filsystem som gör att ett MapReduce-jobb kan läsas från MongoDB® direkt utan att först kopiera det till HDFS (Hadoop-filsystem), vilket tar bort behovet för att flytta terabyte data över nätverket.

- MapReduce-jobb kan skicka frågor som filter, så att man undviker behovet av att skanna hela samlingar, och kan också dra fördel av MongoDB®s rika indexeringsmöjligheter inklusive geospatial, text- sök-, array-, sammansatta och glesa index.

- Läser från MongoDB® kan resultaten av Hadoop-jobb också skrivas tillbaka till MongoDB® för att stödja driftprocesser i realtid och ad-hoc-frågor.

Hadoop och MongoDB® Användningsfall:

Låt oss titta på en beskrivning på hög nivå av hur MongoDB® och Hadoop kan passa ihop i en typisk Big Data-stack. I första hand har vi:

- MongoDB® används som "Operational" realtidsdatalager

- Hadoop för offline batchdatabearbetning och analys

Läs vidare för att veta varför MongoDB är databasen för Big Data-bearbetning ochhur MongoDB® användes av företag och organisationer som Aadhar, Shutterfly, Metlife och eBay.

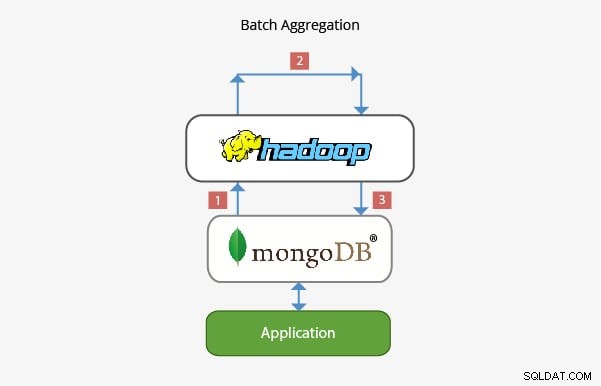

Applicering av MongoDB® med Hadoop i Batch Aggregation:

I de flesta scenarier är den inbyggda aggregeringsfunktionaliteten som tillhandahålls av MongoDB® tillräcklig för att analysera data. I vissa fall kan dock betydligt mer komplex dataaggregering vara nödvändig. Det är här Hadoop kan tillhandahålla ett kraftfullt ramverk för komplexa analyser.

I det här scenariot:

- Data hämtas från MongoDB® och bearbetas inom Hadoop via ett eller flera MapReduce-jobb. Data kan också hämtas från andra platser inom dessa MapReduce-jobb för att utveckla en lösning med flera datakällor.

- Utdata från dessa MapReduce-jobb kan sedan skrivas tillbaka till MongoDB® för förfrågningar i ett senare skede och för eventuell analys på ad hoc-basis.

- Applikationer byggda ovanpå MongoDB® kan därför använda informationen från batchanalys för att presentera för slutklienten eller för att aktivera andra nedströmsfunktioner.

Applikation i Data Warehousing:

I en typisk produktionsinstallation kan programmets data finnas i flera datalager, var och en med sitt eget frågespråk och funktionalitet. För att minska komplexiteten i dessa scenarier kan Hadoop användas som ett datalager och fungera som ett centraliserat arkiv för data från de olika källorna.

I den här typen av scenario:

- Periodic MapReduce-jobb laddar data från MongoDB® till Hadoop.

- När data från MongoDB® och andra källor är tillgängliga i Hadoop, kan den större datamängden frågas mot.

- Dataanalytiker har nu möjlighet att använda antingen MapReduce eller Pig för att skapa jobb som frågar de större datamängderna som innehåller data från MongoDB®.

Teamet som arbetar bakom MongoDB® har säkerställt att det med sin rika integration med Big Data-tekniker som Hadoop kan integreras väl i Big Data Stack och hjälpa till att lösa vissa komplexa arkitekturproblem när det kommer till datalagring, hämtning, bearbetning, aggregering och lagerhållning. Håll utkik efter vårt kommande inlägg om karriärmöjligheter för dem som tar upp Hadoop med MongoDB®. Om du redan arbetar med Hadoop eller bara hämtar MongoDB®, kolla in kurserna vi erbjuder för MongoDB® här

Utforska mer om Hadoop-koncept. Kolla in den här Big Data Online-kursen , som skapades av Top Industrial Working Experts.