I denna Big data Hadoop-handledning , kommer vi att ge dig en detaljerad beskrivning av Hadoop HDFS-datablock. Först och främst kommer vi att täcka vad som är datablock i Hadoop, vad är deras betydelse, varför storleken på HDFS-datablock är 128 MB.

Vi kommer också att diskutera exemplet med datablock i hadoop och olika fördelar med HDFS i Hadoop.

Introduktion till HDFS-datablock

Hadoop HDFS dela upp stora filer i små bitar som kallas block . Block är den fysiska representationen av data. Den innehåller en minsta mängd data som kan läsas eller skrivas. HDFS lagrar varje fil som block. HDFS-klienten har ingen kontroll på blocket som blockets plats, Namenode bestämmer alla sådana saker.

Som standard är HDFS-blockstorleken 128 MB som du kan ändra enligt dina önskemål. Alla HDFS-block har samma storlek utom det sista blocket, som antingen kan ha samma storlek eller mindre.

Hadoop-ramverket delar upp filer i 128 MB-block och lagras sedan i Hadoop-filsystemet. Apache Hadoop-applikationen ansvarar för att distribuera datablocket över flera noder.

Exempel-

Anta att filstorleken är 513 MB och att vi använder standardkonfigurationen för blockstorleken 128 MB. Sedan kommer Hadoop-ramverket att skapa 5 block, de första fyra blocken 128 MB, men det sista blocket kommer att vara på endast 1 MB.

Av exemplet är det alltså tydligt att det inte är nödvändigt att i HDFS varje lagrad fil ska vara en exakt multipel av den konfigurerade blockstorleken 128mb, 256mb etc. Därför använder slutblocket för fil bara så mycket utrymme som behövs.

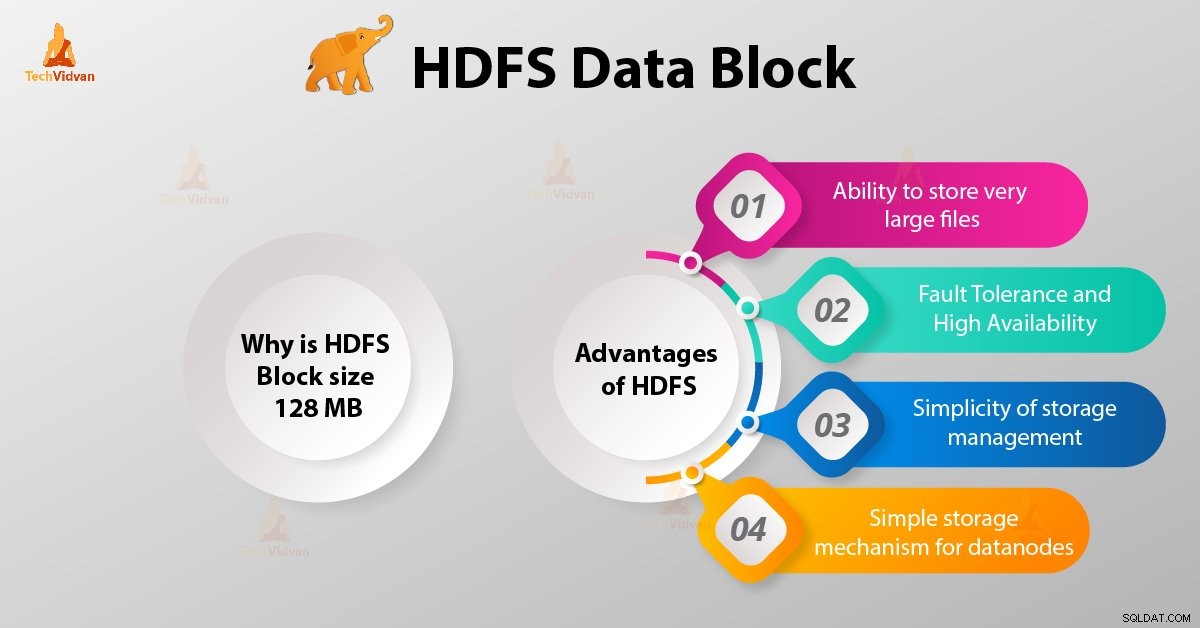

Varför är HDFS-blockstorleken 128 MB?

HDFS lagrar terabyte och petabyte med data. Om HDFS-blockstorleken är 4kb som Linux-filsystemet, kommer vi att ha för många datablock i Hadoop HDFS, därför för mycket metadata.

Så att underhålla och hantera detta enorma antal block och metadata kommer att skapa enorma overhead och trafik, vilket är något vi inte vill ha.

Blockstorleken kan inte vara så stor att systemet väntar väldigt länge på att en sista enhet av databehandling ska avsluta sitt arbete.

Fördelar med HDFS

Efter att ha lärt oss vad som är HDFS Data Block, låt oss nu diskutera fördelarna med Hadoop HDFS.

1. Möjlighet att lagra mycket stora filer

Hadoop HDFS lagrar mycket stora filer som är till och med större än storleken på en enda disk eftersom Hadoop-ramverket delar upp filer i block och distribuerar över olika noder.

2. Feltolerans och hög tillgänglighet för HDFS

Hadoop-ramverket kan enkelt replikera block mellan datanoderna. Ge därför feltolerans och hög tillgänglighet HDFS.

3. Enkel lagringshantering

Eftersom HDFS har fast blockstorlek (128MB), så är det mycket enkelt att beräkna antalet block som kan lagras på disken.

4. Enkel lagringsmekanism för datanoder

Block i HDFS förenklar lagringen avDatanoderna . Namnod upprätthåller metadata för alla block. HDFS Datanode behöver inte bry sig om blockmetadata som filbehörigheter etc.

Slutsats

Därför är HDFS-datablock den minsta dataenheten i ett filsystem. Standardstorleken på HDFS-blocket är 128 MB som du kan konfigurera enligt kraven. HDFS-block är lätta att replikera mellan datanoderna. Ge därför feltolerans och hög tillgänglighet för HDFS.

För alla frågor eller förslag relaterade till Hadoop HDFS-datablock, låt oss veta det genom att lämna en kommentar i ett avsnitt nedan.